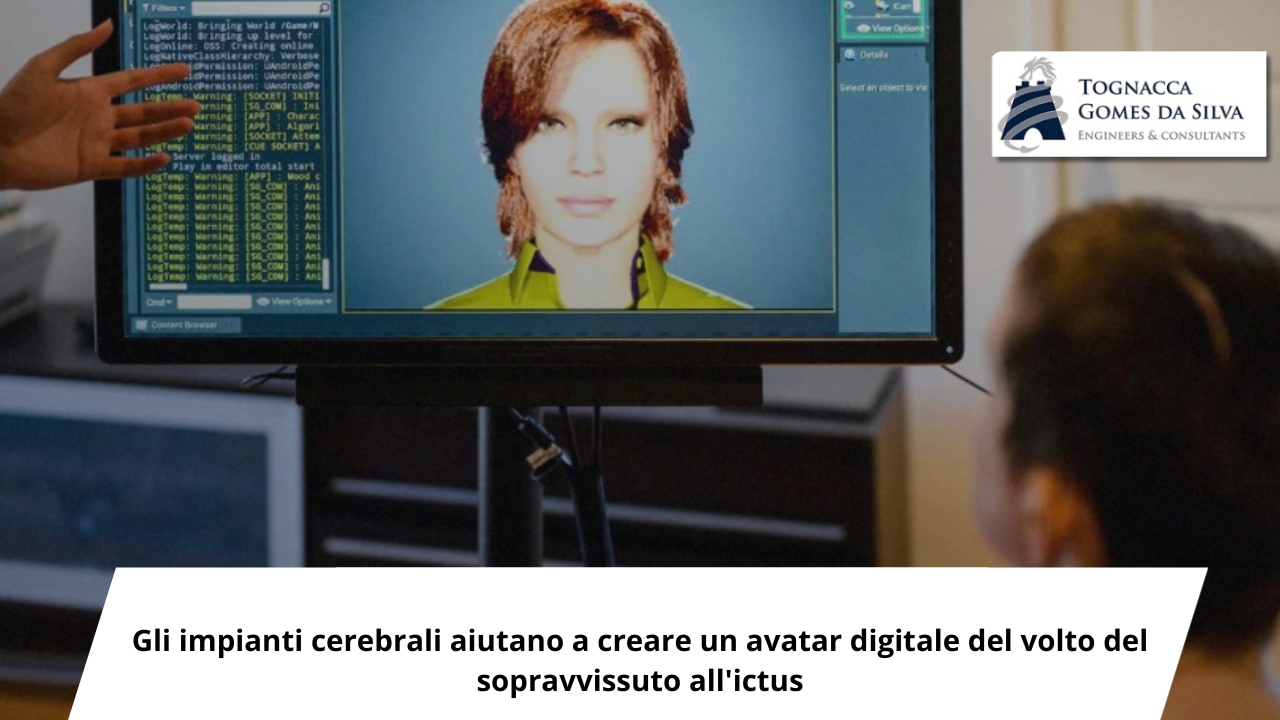

“Cosa ne pensi della mia voce artificiale?” chiede una donna sullo schermo del computer, con gli occhi verdi leggermente spalancati. L’immagine è chiaramente computerizzata e la voce è esitante, ma è comunque un momento memorabile. È l’avatar digitale di una persona che ha perso la capacità di parlare dopo aver subito un ictus 18 anni fa. Ora, come parte di un esperimento che coinvolge un impianto cerebrale e algoritmi di intelligenza artificiale (AI), il paziente può comunicare con una riproduzione della propria voce e persino esprimere una serie limitata di espressioni facciali attraverso il suo avatar.

Due articoli pubblicati a fine agosto su Nature e realizzati da due gruppi di ricerca indipendenti mostrano la rapidità con cui si sta avanzando in questo settore, sebbene questi prototipi siano ancora lontani dall’essere accessibili al pubblico. Ciascuno studio prevedeva la partecipazione di una donna che aveva perso la capacità di esprimersi chiaramente, una a causa di un ictus al tronco encefalico e l’altra a causa della sclerosi laterale amiotrofica (SLA), una malattia neurodegenerativa progressiva.

A ogni partecipante era stato impiantato nel cervello un diverso tipo di dispositivo di registrazione ed entrambi erano in grado di parlare a una velocità di circa 60-70 parole al minuto. Si tratta di circa la metà della velocità del parlato normale, ma più di quattro volte più veloce di quanto riportato in precedenza. Un team guidato da Edward Chang, neurochirurgo dell’Università della California, San Francisco (USA), ha anche catturato i segnali cerebrali che controllano i piccoli movimenti che rendono possibili le espressioni facciali, permettendo loro di creare un avatar che rappresentasse il discorso del partecipante. lo studio quasi in tempo reale.

Gli articoli “sono un esempio di scienza e ingegneria del cervello davvero sofisticate e metodiche”, afferma Judy Illes, neuroeticista dell’Università della British Columbia a Vancouver, in Canada, che non è stata coinvolta in nessuno dei due studi. A Illes è piaciuto particolarmente creare un avatar espressivo. “La comunicazione non implica solo lo scambio di parole tra le persone. Si tratta di parole e messaggi comunicati attraverso l’intonazione, l’espressione, l’accento, il contesto”, afferma. “Penso che sia stato creativo ed estremamente ben pensato cercare di incorporare questa componente dell’individualità in campi come la scienza fondamentale, l’ingegneria e la neurotecnologia”.

Chang e il suo team lavorano su questo problema da più di un decennio. Nel 2021, hanno dimostrato di poter registrare l’attività cerebrale di una persona che aveva subito un ictus al tronco cerebrale e convertire questi segnali in parole e frasi scritte, anche se lentamente. Nell’ultimo articolo, il team ha utilizzato un impianto più grande (un dispositivo delle dimensioni di una carta di credito), con il doppio del numero di elettrodi, per catturare segnali dal cervello di un altro paziente, di nome Ann, che ha perso la capacità di parlare dopo un fuoriuscita quasi due decenni fa.

L’impianto non registra i pensieri. Cattura invece i segnali elettrici che controllano i movimenti muscolari delle labbra, della lingua, della mascella e delle corde vocali, che consentono la parola. Ad esempio, “se emetti un suono P o B, ciò implica avvicinare le labbra. Questo, a sua volta, attiverebbe una certa porzione degli elettrodi coinvolti nel controllo delle labbra”, afferma Alexander Silva, autore dello studio e studente laureato nel laboratorio di Chang. Un connettore, posizionato sul cuoio capelluto del paziente, consente al personale di trasferire questi segnali a un computer, dove gli algoritmi di intelligenza artificiale li decodificano e un modello linguistico aiuta a fornire capacità di autocorrezione per migliorare l’accuratezza della conversione. Utilizzando questa tecnologia, il team ha tradotto l’attività cerebrale di Ann in parole scritte a una velocità di 78 parole al minuto, utilizzando un vocabolario di 1.024 parole, con un tasso di errore del 23%.

Il gruppo di Chang è stato anche in grado di decodificare i segnali cerebrali direttamente dalle parole pronunciate, una novità assoluta per qualsiasi gruppo. E i segnali muscolari catturati hanno permesso al partecipante di esprimere, attraverso l’avatar, tre diverse emozioni (felice, triste e sorpresa) a tre diversi livelli di intensità. “La parola non è solo una semplice comunicazione di parole, ma è anche parte di ciò che siamo. La nostra voce e le nostre espressioni fanno parte della nostra identità”, afferma Chang. Il partecipante allo studio spera di diventare un consulente. “È il mio grande obiettivo”, ha detto ai ricercatori. Crede che, utilizzando questo tipo di avatar, potrebbe far sentire più a proprio agio i suoi clienti. Il team ha utilizzato una registrazione video del suo matrimonio per replicare la sua voce, quindi l’avatar sembrava addirittura lei.

Il secondo team, guidato da ricercatori di Stanford (USA), ha pubblicato per la prima volta i risultati come prestampa a gennaio. I ricercatori hanno inserito quattro impianti molto più piccoli (ciascuno delle dimensioni di un’aspirina), in grado di registrare segnali dalle cellule nervose, in un partecipante affetto da SLA di nome Pat Bennett, che ha addestrato il sistema leggendo sillabe, parole e frasi in 25 sessioni.

I ricercatori hanno poi testato la tecnologia facendole leggere frasi che non erano state usate durante l’addestramento. Quando sono stati estratti da un insieme di 50 parole, il tasso di errore era di circa il 9%. Quando il team ha ampliato il vocabolario a 125.000 parole, che coprono gran parte della lingua inglese, il tasso di errore è salito a circa il 24%.

Il parlato che utilizza queste interfacce non è perfetto. È ancora più lento del normale e, sebbene un tasso di errore del 23% o 24% sia molto migliore rispetto ai risultati precedenti, non è ancora l’ideale. In alcuni casi, il sistema replicava perfettamente le frasi. In altri, “Come va il raffreddore?” (Come va il raffreddore?) è uscito come “Come vanno i tuoi anni?” (Come sta il tuo vecchio?).

Ma gli scienziati sono convinti di poter fare meglio. “La cosa interessante è che man mano che si aggiungono più elettrodi, le prestazioni del decodificatore continuano ad aumentare”, afferma Francis Willett, neuroscienziato di Stanford e autore dell’articolo. “Se riusciamo a ottenere più elettrodi per decodificare ancora più neuroni, possiamo essere ancora più accurati”.

I sistemi attuali non sono pratici nelle situazioni quotidiane. Poiché si affidano a connessioni cablate e a un sistema informatico troppo grande per gestire l’elaborazione, le donne non possono utilizzare gli impianti cerebrali per comunicare al di fuori del contesto dell’esperimento. “C’è ancora molto lavoro da fare per trasformare questa conoscenza in qualcosa di utile per le persone con bisogni non soddisfatti”, afferma Nick Ramsey, neuroscienziato dell’UMC Utrecht Brain Center, ad Amsterdam (Paesi Bassi), e autore di un’analisi pubblicata insieme a gli articoli.

Illes attira inoltre l’attenzione sul fatto che ogni squadra riporta i risultati di un singolo individuo e questi potrebbero non essere validi per altre persone, anche quelle con condizioni neurologiche simili. “Ciò convalida l’idea iniziale”, afferma. “Sappiamo che le lesioni cerebrali sono molto complesse e altamente variabili. La generalizzazione dei risultati, anche all’interno della popolazione di pazienti con ictus o SLA, è possibile, ma non certa”.

Tuttavia, crea la possibilità di una soluzione tecnologica per le persone che perdono la capacità di comunicare. “Ciò che abbiamo fatto è stato dimostrare che è eseguibile e che esiste un percorso per realizzarlo”, afferma Chang.

Saper parlare è fondamentale. Il partecipante allo studio di Chang utilizzava spesso una lavagna per comunicare. “Mio marito era stanco di doversi alzare e decifrare la lavagna per me”, ha detto ai ricercatori. “Non abbiamo litigato, perché non mi ha dato la possibilità di ribattere. Come puoi immaginare, questo mi ha frustrato molto! Secondo la direttrice medica della Riabilitazione dell’Ospedale Israelita Albert Einstein, Milene Ferreira, i disturbi neurologici rappresentano la seconda causa di disabilità nella popolazione mondiale.

“La perdita della capacità comunicativa è uno dei principali fattori di riduzione dell’autonomia, della produttività e della soddisfazione. L’incapacità di esprimere ciò che si pensa o si desidera viene descritta da molti pazienti come molto più angosciante o limitante delle difficoltà motorie. Questo contesto di studio non solo fa luce su questo tipo di deficit, ma apre anche la strada ad altri esperimenti volti a catturare e tradurre l’attività cerebrale applicata alla riabilitazione e all’inclusione”, osserva Milene.

L’opinione di coloro che lavorano direttamente con la riabilitazione dei pazienti è che la ricerca sull’interfaccia cervello-macchina dipende dall’integrazione di diverse aree di conoscenza. Per lo specialista, sono ancora necessari molti progressi per rendere disponibili alle persone soluzioni applicabili.

(Fonte: MIT Technology Review)