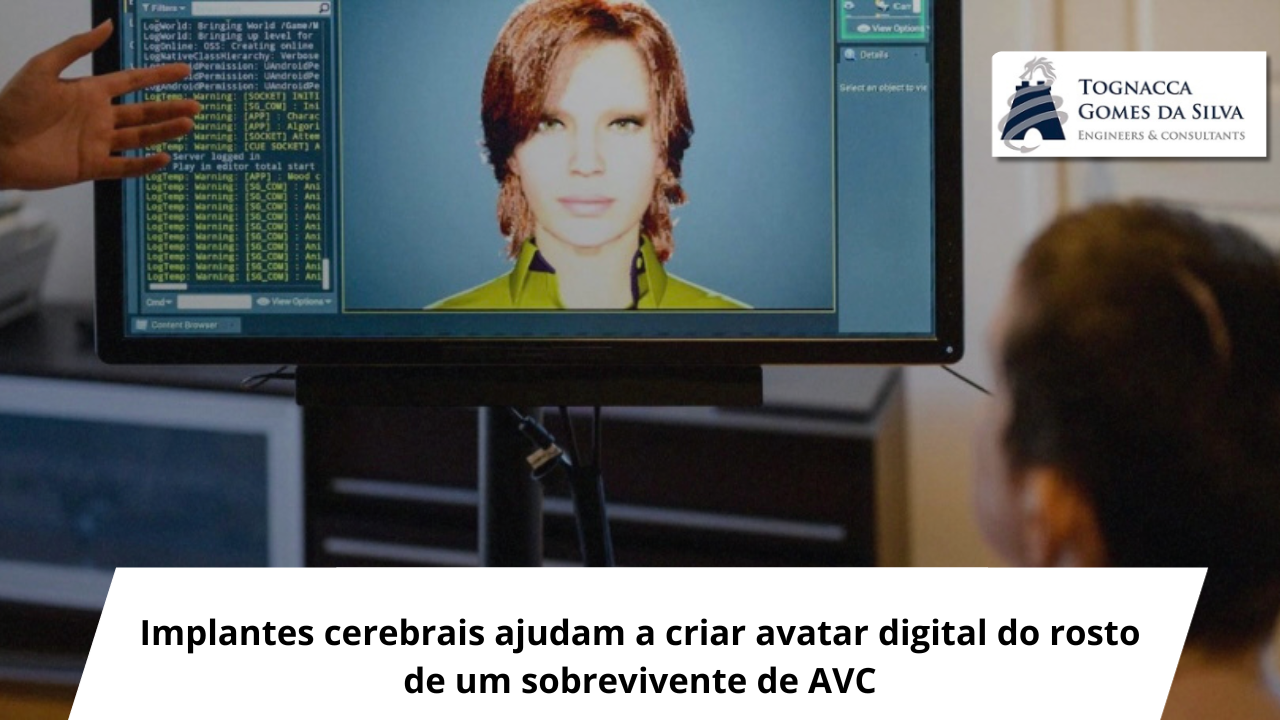

“O que você acha da minha voz artificial?”, pergunta uma mulher na tela do computador, com seus olhos verdes arregalando-se ligeiramente. A imagem é claramente computadorizada e a voz, hesitante, mas ainda assim é um momento memorável. Ela é um avatar digital de uma pessoa que perdeu a capacidade de falar após ter sofrido um derrame há 18 anos. Agora, como parte de um experimento que envolve um implante cerebral e algoritmos de Inteligência Artificial (IA), a paciente pode se comunicar com uma reprodução de sua própria voz e até mesmo manifestar um conjunto limitado de expressões faciais por meio de seu avatar.

Dois artigos publicados no final de agosto na Nature e produzidos por duas equipes de pesquisa independentes mostram a rapidez com que essa área está avançando, embora esses protótipos ainda estejam longe de serem acessíveis ao público. Cada estudo contou com a participação de uma mulher que perdeu a capacidade de se expressar de forma clara, uma após um acidente vascular cerebral (AVC) no tronco encefálico e a outra devido à Esclerose Lateral Amiotrófica (ELA), uma doença neurodegenerativa progressiva.

Cada participante teve um tipo diferente de dispositivo de gravação implantado em seu cérebro, e ambas conseguiram falar a uma taxa de cerca de 60 a 70 palavras por minuto. Isso é aproximadamente metade da velocidade da fala normal, mas mais de quatro vezes mais rápido do que havia sido relatado anteriormente. Uma equipe liderada por Edward Chang, neurocirurgião da Universidade da Califórnia, em São Francisco (EUA), também capturou os sinais cerebrais que controlam os pequenos movimentos que possibilitam a execução das expressões faciais, permitindo-lhes criar um avatar que representava a fala da participante do estudo quase em tempo real.

Os artigos “são um exemplo de ciência e engenharia realmente sofisticadas e metódicas para o cérebro”, diz Judy Illes, neuroeticista da Universidade da Colúmbia Britânica, em Vancouver, Canadá, que não esteve envolvida em nenhum dos estudos. Illes gostou especialmente da criação de um avatar expressivo. “A comunicação não envolve apenas a troca de palavras entre pessoas. Trata-se de palavras e mensagens comunicadas por meio de entoação, expressão, sotaque, contexto”, afirma. “Acho que foi criativo e extremamente bem pensado tentar incorporar esse componente da individualidade em campos como a ciência fundamental, engenharia e neurotecnologia”.

Chang e sua equipe têm trabalhado nessa questão há mais de uma década. Em 2021, eles demonstraram que poderiam registrar a atividade cerebral de uma pessoa que havia sofrido um AVC no tronco cerebral e converter esses sinais em palavras e frases escritas, embora de forma lenta. No último artigo, a equipe usou um implante maior (um dispositivo do tamanho de um cartão de crédito), com o dobro do número de eletrodos, para capturar sinais do cérebro de outra paciente, chamada Ann, que perdeu a capacidade de falar após um derrame há quase duas décadas.

O implante não registra pensamentos. Em vez disso, ele captura os sinais elétricos que controlam os movimentos musculares dos lábios, língua, mandíbula e cordas vocais, todos os que permitem a fala. Por exemplo, “se você fizer um som P ou B, isso envolve aproximar os lábios um do outro. Isso, por sua vez, ativaria uma certa porção dos eletrodos envolvidos no controle dos lábios”, diz Alexander Silva, autor do estudo e aluno de pós-graduação no laboratório de Chang. Um conector, posicionado no couro cabeludo da paciente, permite que a equipe transfira esses sinais para um computador, onde algoritmos de IA os decodificam e um modelo de linguagem ajuda a fornecer recursos de autocorreção para melhorar a precisão da conversão. Com essa tecnologia, a equipe traduziu a atividade cerebral de Ann em palavras escritas a uma taxa de 78 palavras por minuto, utilizando um vocabulário de 1.024 palavras, com uma taxa de erro de 23%.

O grupo de Chang também conseguiu decodificar sinais cerebrais diretamente em palavras faladas, uma inovação inédita em qualquer grupo. E os sinais musculares capturados permitiram que a participante expressasse, por meio do avatar, três emoções diferentes (feliz, triste e surpresa) em três níveis diferentes de intensidade. “A fala não se trata apenas de uma simples comunicação de palavras, mas também é parte de quem somos. Nossa voz e expressões fazem parte da nossa identidade”, diz Chang. A participante do estudo espera se tornar uma conselheira. “É o meu grande objetivo”, disse aos pesquisadores. Ela acredita que, ao utilizar esse tipo de avatar, poderia fazer com que seus clientes se sentissem mais à vontade. A equipe usou uma gravação do vídeo de seu casamento para replicar sua voz, de modo que o avatar até soasse como ela mesmo.

A segunda equipe, liderada por pesquisadores de Stanford (EUA), publicou pela primeira vez seus resultados como pré-impressão em janeiro. Os pesquisadores inseriram quatro implantes muito menores (cada um do tamanho de uma aspirina), capazes de registrar sinais de células nervosas, em uma participante com ELA, chamada Pat Bennett, que treinou o sistema lendo sílabas, palavras e frases ao longo de 25 sessões.

Os pesquisadores então testaram a tecnologia, fazendo com que ela lesse frases que não haviam sido usadas durante o treinamento. Quando elas foram extraídas de um conjunto de 50 palavras, a taxa de erro foi de cerca de 9%. Quando a equipe expandiu o vocabulário para 125 mil palavras, o que abrange grande parte da língua inglesa, a taxa de erro subiu para cerca de 24%.

A fala usando essas interfaces não é perfeita. Ainda é mais lenta do que o normal e, embora uma taxa de erro de 23% ou 24% seja muito melhor que os resultados anteriores, ainda não é o ideal. Em alguns casos, o sistema replicou frases perfeitamente. Em outros, “How is your cold?” (Como está seu resfriado?) saiu como “How is your old?” (Como está o seu velho?).

Mas os cientistas estão convencidos de que podem fazer melhor. “O interessante é que à medida que você adiciona mais eletrodos o desempenho do decodificador continua aumentando”, diz Francis Willett, neurocientista e autor do artigo de Stanford. “Se conseguirmos mais eletrodos para decodificar ainda mais neurônios, poderemos ser ainda mais precisos”.

Os sistemas atuais não são práticos em situações do dia a dia. Como dependem de conexões com fio e de um sistema de computador grande demais para lidar com o processamento, as mulheres não podem usar os implantes cerebrais para se comunicarem fora do contexto do experimento. “Ainda há muito trabalho a ser feito para transformar este conhecimento em algo útil para pessoas com necessidades não atendidas”, afirma Nick Ramsey, neurocientista do UMC Utrecht Brain Center, em Amsterdã (Holanda), e autor de uma análise publicada junto aos artigos.

Illes também chama a atenção ao fato de que cada equipe relata resultados de um único indivíduo, e eles podem ser inválidos para outras pessoas, mesmo aquelas com condições neurológicas semelhantes. “Isso valida a ideia inicial”, diz ela. “Sabemos que lesões cerebrais são muito complexas e altamente variáveis. A generalização de resultados, mesmo dentro da população de pacientes com AVC ou com ELA, é possível, mas não é certa”.

Entretanto, cria a possibilidade de uma solução tecnológica para pessoas que perdem a capacidade de comunicar. “O que fizemos foi provar que é executável e que existe um caminho para se realizar isso”, diz Chang.

Ser capaz de falar é crucial. A participante do estudo de Chang costumava usar um quadro de letras para se comunicar. “Meu marido estava cansado de ter que se levantar e decifrar o quadro para mim”, disse ela aos pesquisadores. “Nós não discutíamos, porque ele não me dava a chance de argumentar de volta. Como você pode imaginar, isso me frustrava muito!”

Segundo a gerente-médica de Reabilitação do Hospital Israelita Albert Einstein, Milene Ferreira, transtornos neurológicos respondem pela segunda maior causa de incapacidade da população mundial.

“A perda da capacidade de comunicação é um dos principais fatores para a redução da autonomia, produtividade e satisfação. Não conseguir manifestar o que pensa ou deseja é descrito como muito mais angustiante ou limitante do que dificuldades motoras por muitos pacientes. Esse contexto de estudo não apenas traz luz para esse tipo de déficit, mas também abre caminho para outros experimentos direcionados para a captação e tradução da atividade cerebral aplicados à reabilitação e inclusão”, observa Milene.

A visão de quem trabalha diretamente com a reabilitação de pacientes é a de que as pesquisas de interface cérebro-máquina dependem da integração de várias áreas do conhecimento. Para a especialista, ainda é preciso evoluir muito para disponibilizar às pessoas soluções com aplicabilidade.

(Fonte: MIT Technology Review )